Dos dados para a ação: curiosidades, conceitos e a operação por trás do big data.

30 de junho de 2019O desafio de realizar tarefas e tomar decisões cada vez mais rápido e com a maior assertividade e eficiência possível é algo que cada vez mais atormenta gestores, empreendedores e executivos.

Crescemos ouvindo que “a pressa é inimiga da perfeição”, mas esse chavão não vale nada quando olhamos para a evolução tecnológica e todos os impactos que ela traz na vida das pessoas e no cotidiano das empresas.

Métodos ágeis, capacidade de processamento, inteligência em dados, decisões assertivas, algoritmos, plataformas, norteiam as cadeias de valor e dão o tom da competitividade, substituindo exponencialmente a inteligência emocional e as decisões intuitivas.

Grandes quantidades de dados tem um valor crescente de mercado pelas imensas possibilidades de aplicação e têm gerado muita atenção e calafrios em muita gente nos últimos anos.

Mas quem viu o filme “O Jogo da Imitação” pôde ver um pouco da saga do do criptoanalista britânico Alan Turing para interpretar padrões e gerar insights à partir grandes massas de dados com equipamentos do tamanho de uma sala.

O problema não era a quantidade de dados em si, mas a falta da capacidade de processamento para minerá-los. E isso vêm mudando ao longo dos anos, como previu Gordon Earl Moore, nos idos da década de 60. Ele foi o responsável pela “Lei de Moore”, que previa que a capacidade de processamento dos computadores dobraria a cada 18 meses.

Essa evolução foi fundamental para que o avanço tecnológico fosse avassalador nas últimas décadas e, conseqüentemente, para que as grandes massas de dados pudessem ser processadas.

Alguns marcos importantes nesse cenário são os anos 97/2000, quando o termo “big data” surge, com Varian e Lyman prevendo a exponencialidade de dados e os possíveis problemas que surgiriam.

Já em 2005 surge o Hadoop (plataforma de software de computação distribuída voltada para clusters e processamento de grandes volumes de dados) e também o termo Data Science. Também a cluster computing surge posteriormente e ajuda muito, com várias máquinas trabalhando em conjunto, num processamento distribuído pelos cores dessas máquinas.

Buscando conceituar o termo “Big Data”, podemos dizer que significa uma enorme quantidade de dados (in ou out), complexos (estruturados e não estruturados), crescente, abrangendo e se utilizando de técnicas já desenvolvidas de BI, Data Mining, Machine Learning (e usando novas).

É interessante ver que a escala de dados dos cidadãos comuns, em seus computadores pessoais, pendrives, cartões de memória e armazenamento em nuvem, é mensurada na casa dos gigabytes e terabytes (ainda me lembro do meu primeiro pen drive de 512 mb, cerca de 10 anos atrás).

Facebook e Google trafegam na ordem dos zettabytes. Daí em diante estamos focando em massas da ordem dos peta e exabytes, sendo que em poucos anos chegaremos nos yottabytes e brontobytes.

Só para se ter uma ideia de como a tecnologia avançou absurdamente rápido nesse campo, em 1990 cada giga custava 10 mil dólares para ser armazenado. Hoje temos 15 gigas free no Google e 1tera por 100 dólares anuais no Dropbox. Tudo isso em nuvem.

As aplicações são quase infinitas: prevenção de fraudes, previsão de vendas, churn (quando o usuário deixar utilizar os serviços), saúde, análise de crédito, realização de pesquisas, históricos de comportamento, qualificação de leads, análises de exames médicos, dentre outras milhões de possibilidades.

Um exemplo fantástico dessa enormidade de dados vem do motor PW1900G, da fabricante Pratt & Whitney, que vai oferecer reduções significantes de consumo, emissão de poluentes e chegará a ser até 50% mais silencioso que os motores atuais. Trata-se de um motor que terá 5000 sensores e produzirá 10 gigabytes de dados por segundo, o que redundará em quase 900 terabytes de dados a cada 12 horas de voo diárias.

Os desafios de organizar e analisar essa massa de dados são imensos, lembrando que esse número trata de apenas um motor.

No quadro a seguir, temos uma pequena amostra do que acontece nas grandes plataformas em míseros 60 segundos. (se quiser entender um pouco mais o poder das plataformas, leia nosso artigo AQUI)

A IBM define os 4 V do big data como sendo:

– Volume – 40 zettabytes de dados serão criados até 2020, sendo que hoje surgem 2,5 quintilhões de bytes por dia.

– Velocidade de geração e de análise – Tempo real, tempo próximo, periodicamente e batch (interações de tempos em tempos, mas em grande escala).

– Variedade de dados, diferentes formas– SMS, áudio, vídeo, web, tabelas, logs, xml, bancos de dados, mobile apps, fotos, dentre outros.

– Veracidade.

Também há alguns pilares de conhecimentos e competências no Data Science que constroem uma abordagem 360°:

– Matemática e estatística- Negócios- Data Mining (encontrar padrão nos dados)

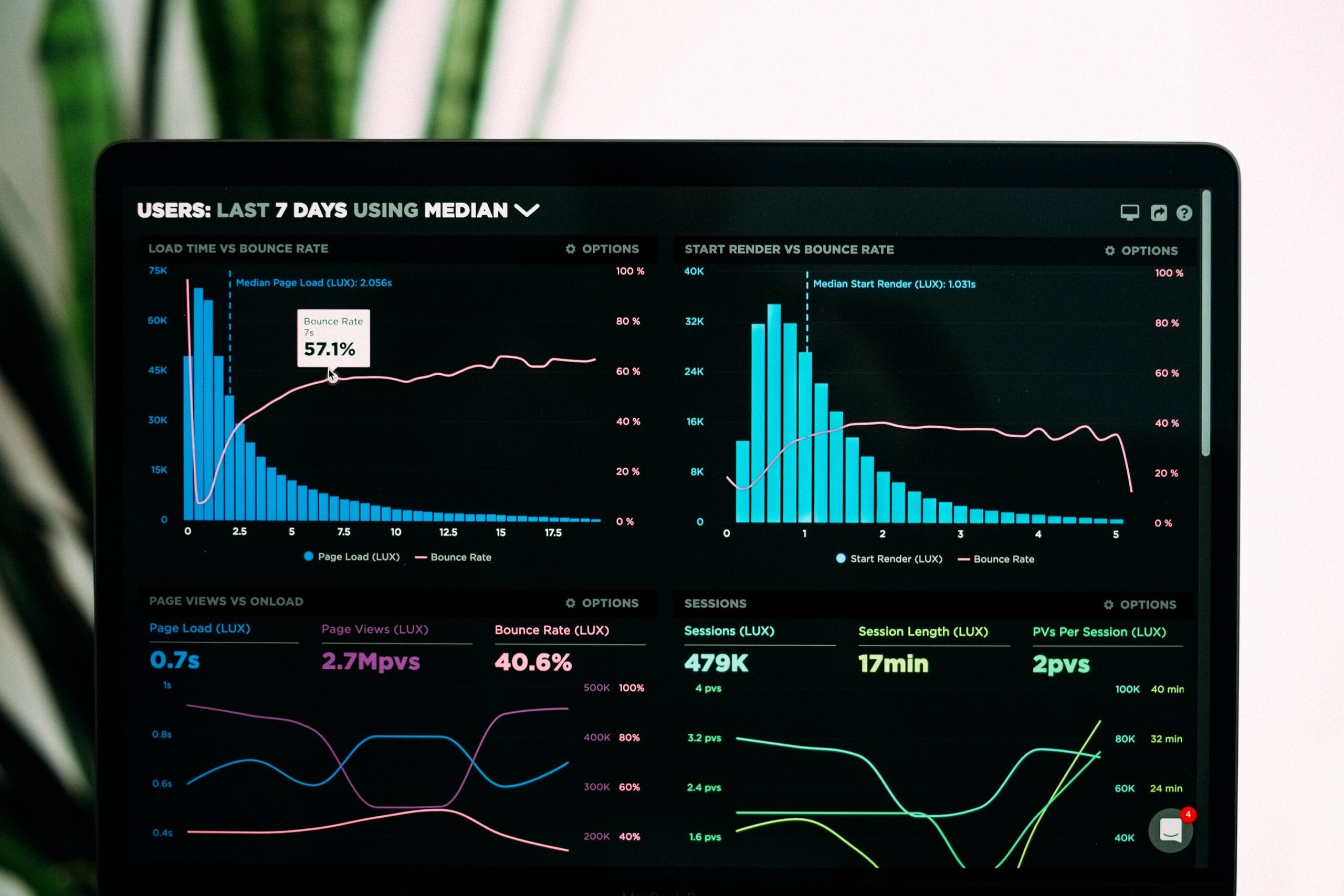

– Visualização de dados (contar histórias com os dados, dashboards fáceis).- Programação (R ou Python)

– Computação- Engenharia de dados –projeção do armazenamento de grandes quantidades de dados.- Pensamento lógico

– Capacidade de analisar os dados e aprender algo novo com eles, agregando valor ao negócio.

E, se uma organização quer se tornar “data driven”, deve investir em estatísticas e análises, com a tomada de decisão fortemente ancorada em dados numéricos, gerando ganhos de eficiência assustadores.

Caminhando para o final dessa reflexão, os principais passos para iniciar uma data analysis seriam:

– Definir o problema/questão

– Definir o data set ideal

– Determinar quais dados poderão ser acessados

– Obter os dados

– Realizar uma análise exploratória

– Fazer a modelagem da predição estatística

– Interpretar os resultados

– Estressar os resultados

– Sintetizar os resultados

– Criar um código reproduzível

E como os profissionais em geral podem tomar partido disso e pular de cabeça? Primeiro é preciso ficar claro toda essa exponencialidade tecnológica vêm ampliando as capacidades da sociedade, abrindo oportunidades para aqueles aptos a se (re)orientar pelas mudanças e entender esses cenários. (para ler o artigo Pensar Digital! clique AQUI)

Dado o mindset ideal, um bom perfil técnico envolveria saber um pouco de tudo, com boas soft skills e facilidade de aprendizagem e desaprendizagem em campos como de matemática estatística, negócios e tecnologias.